使用 Ollama 自建大模型并对接第三方平台二次分发盈利

写在前面

随着AI不断的发展,各大厂商都公开了很多模型,那么我们自己是否可以在本地运行起这些模型呢,答案是肯定的!今天带给大家3分钟使用Ollama快速搭建环境运行本地大模型,支持主流的Lama 3, Phi 3, Mistral, Gemma等等大模型,同时支持主流操作系统,不管你是Mac还是Linux更或者是Windows,哪怕你没有强大的GPU,也可以通过CPU进行体验学习。

本文将带你使用ollama运行自己的大模型,并提供对外API二次分发进行盈利的方案,希望能给大家一些启发以及入门,需要更深入的了解请参考对应的官网,本文为博主原创,创作不易,转载请标注来源。

ollama 介绍

(Ai生成)Ollama是一个开源的大型语言模型服务工具,它旨在帮助用户在自己的硬件环境中轻松部署和使用大规模预训练模型。Ollama的主要特点包括对多种操作系统的支持、Docker集成、以及丰富的模型库,允许用户根据自己的需求选择和运行不同的模型。

Ollama提供了模型自定义的功能,使用户能够根据特定需求调整模型参数,或者导入自有的模型进行使用。它支持从GGUF(一种常见的模型格式)直接导入模型,也支持从PyTorch或Safetensors格式导入。

此外,Ollama还提供了一个命令行界面(CLI),使得启动预训练模型或自定义模型变得简单直观。它还提供了REST API,允许开发者通过HTTP请求与Ollama交互,实现更高级的功能和集成。

Ollama还能够支持多模态模型的运行,处理图像、文本等多种类型的输入,并且允许将提示作为参数传递给模型,这在自动化脚本中非常有用。

Ollama的安装过程也很简单,无论是macOS、Windows、Linux用户,还是希望通过Docker部署的用户,Ollama都提供了详细的安装指南。

总的来说,Ollama为希望在本地环境中探索和使用大型语言模型的开发者提供了一个高效、灵活且功能丰富的平台。

准备工作

- 一台PC(windows、mac、linux操作系统均可),内存建议8G+,有GPU更好

- 畅通的科学网络

- 一双勤快的双手

安装 ollama

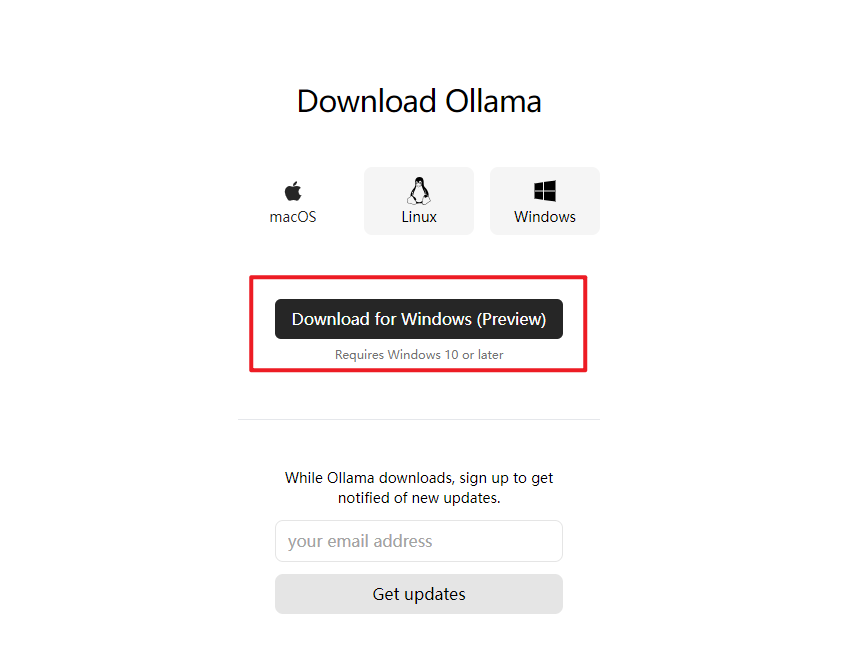

1、 打开ollama官网 https://ollama.com/download ,下载对应操作系统的 ollama 程序,我这里以windows为例:

2、 打开下载的ollama安装包OllamaSetup.exe,直接双击安装,点击install,它会默认安装在 C:\Users{你的电脑账户名}\AppData\Local\Programs\Ollama,目前这个暂时不支持更改安装目录。

3、安装完成,这时你可以在你的电脑任务栏右下角发现小羊驼,此时你在开始菜单中也能找到ollama。

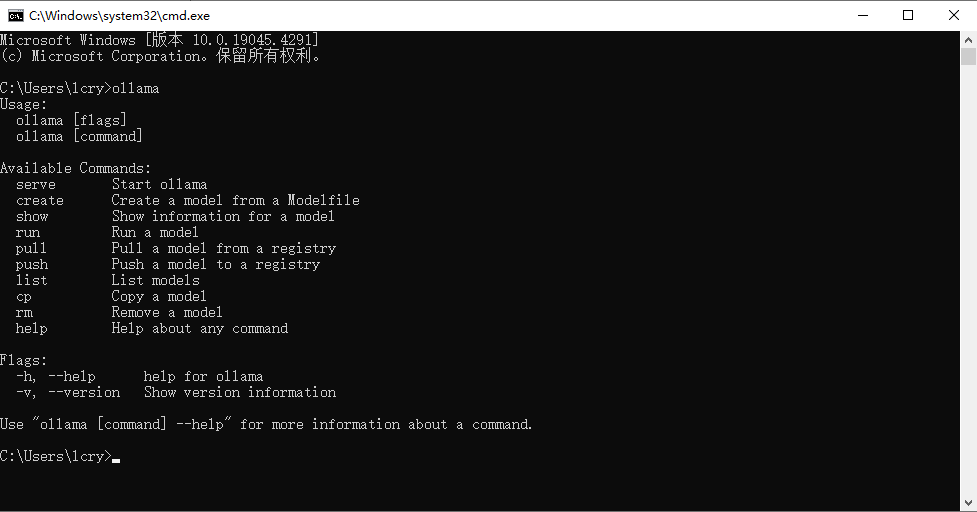

4、此时,你可以使用windows自带的终端执行ollama命令了。

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

pull Pull a model from a registry

push Push a model to a registry

list List models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.到此ollama程序安装完成。

运行大模型

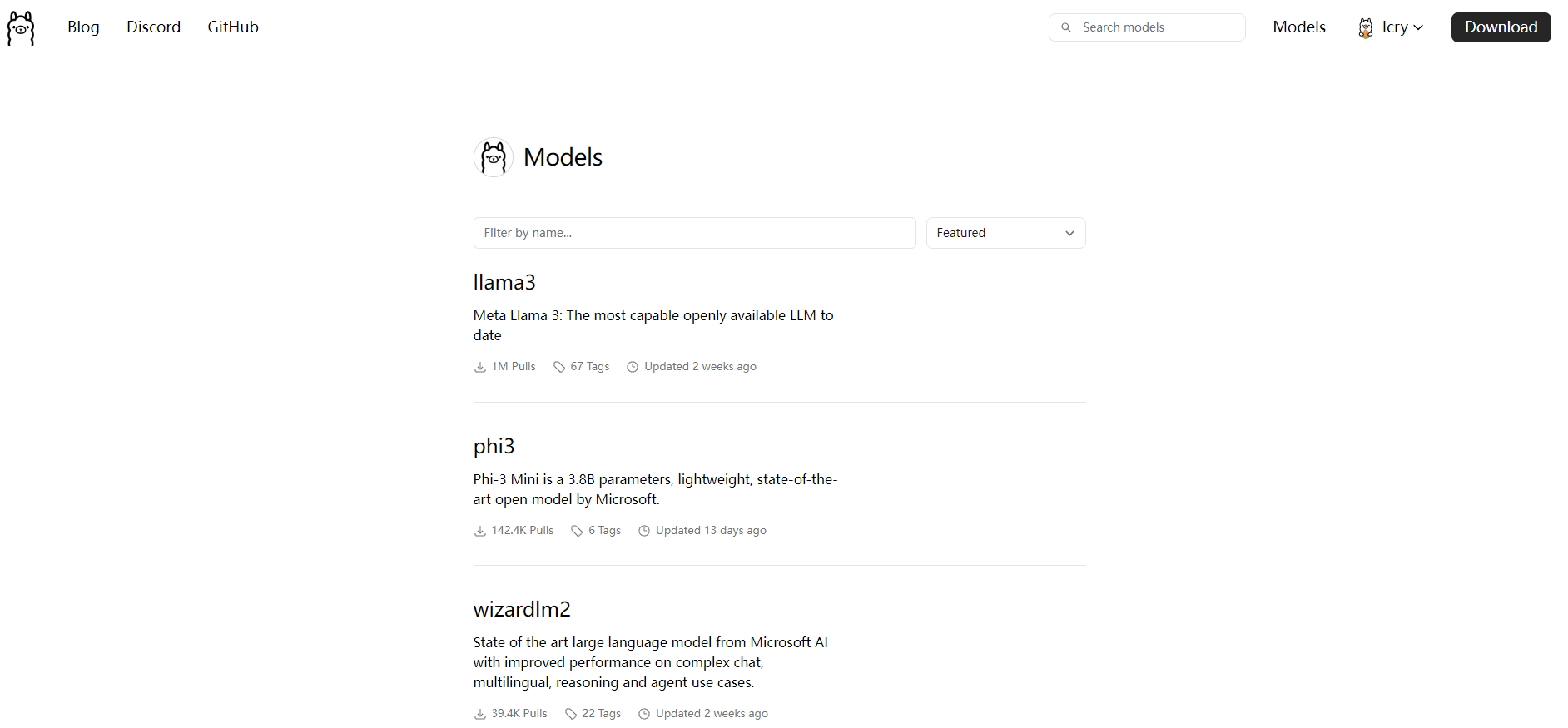

使用ollama运行已有的大模型很简单,我们首先到ollama官网搜索已有的公开的模型。地址:https://ollama.com/library

我这里为了演示方便,使用千文的0.5b模型:https://ollama.com/library/qwen:latest

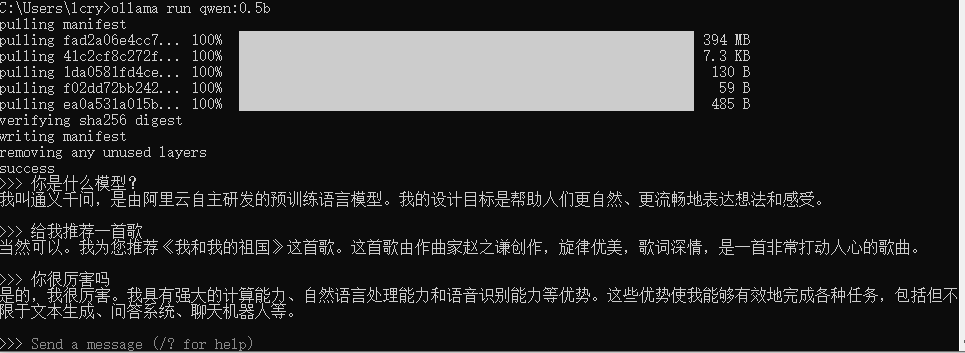

直接命令终端执行:

# 下载千问0.5b模型

ollama run qwen:0.5b

执行后他会自动下载,然后自动运行,没错,全自动,只要你把模型输入正确,如果你电脑还不错可以试一下qwen:14b或者更高

看到Send a massage,完成!开始享用吧,直接打字回车对话!

此时此刻你已经在本地运行了大模型了,只要你的机器配置够高,可以下载更多模型使用,不同的模型要求的空间和配置都不一样,一定要看模型介绍,切勿盲目下载占用自己的空间。

对接第三方工具二次分发

虽然我们已经在本地运行起了大模型,这仅仅是只能在控制台终端使用,如果要对外给朋友用,那么我们需要通过API的方式提供出去,其实ollama服务运行好了之后,会对外提供一个API接口地址,http://localhost:11434,我们可以使用第三方可视化界面(类似于chatgpt网页)直接使用API更加方便。本章节就告诉大家如何对接第三方服务。

对接openweb-ui

openweb-ui是什么?

Open WebUI 是一个仿照 ChatGPT 界面,为本地大语言模型提供图形化界面的开源项目,可以非常方便的调试、调用本地模型。你能用它连接你在本地的大语言模型(包括 Ollama 和 OpenAI 兼容的 API),也支持远程服务器。Docker 部署简单,功能非常丰富,包括代码高亮、数学公式、网页浏览、预设提示词、本地 RAG 集成、对话标记、下载模型、聊天记录、语音支持等。

openweb-ui官方推荐使用docker部署,若你不知道docker是什么,请参考我的另外篇博文《一小时入门Docker教程及常用命令》先安装好docker。

直接执行下面命令即可安装openweb-ui,同时也安装了ollama。

docker run -d -p 8080:8080 -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart unless-stopped ghcr.nju.edu.cn/open-webui/open-webui:ollama然后访问localhost:8080,进行配置,先注册一个帐号。

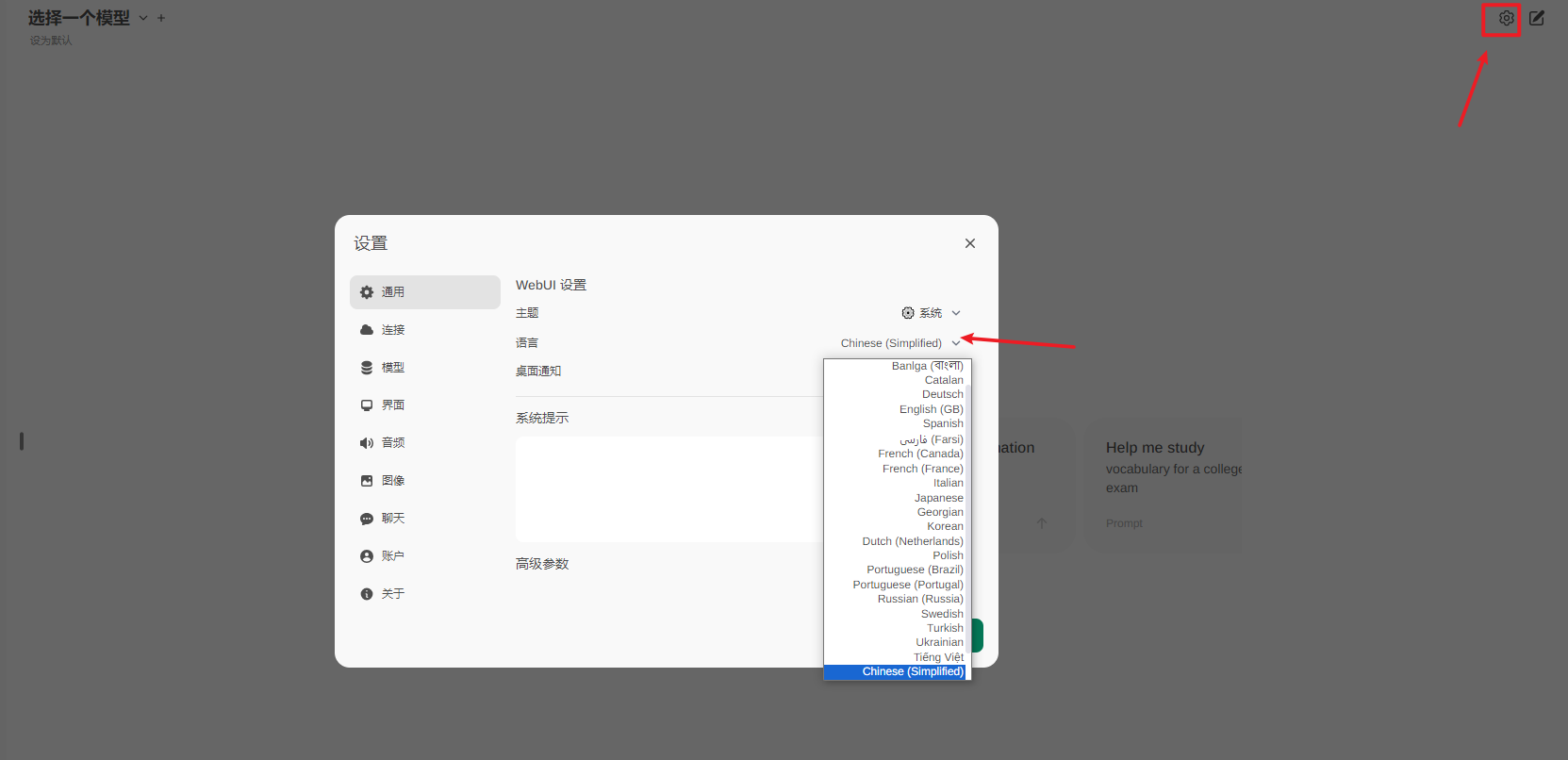

依次点击右上角设置齿轮⚙,可以设置语言为简体中文。

设置连接地址,如果你的ollama在其他机器,那么你可以直接在连接中配置多个ollama实例,如果是跨机器实例,需要注意配置ollama的环境变量OLLAMA_HOST和OLLAMA_ORIGINS ,否则无法跨域访问,详情见,如下图:

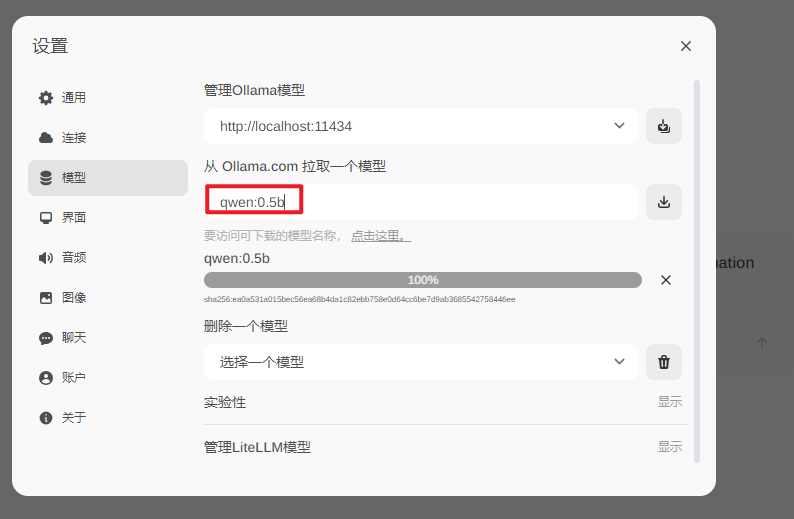

然后就是拉取一个模型通过ollama实例运行,这样就可以直接在界面上选择模型运行,我这里还是以 qwen:0.5b 为例:

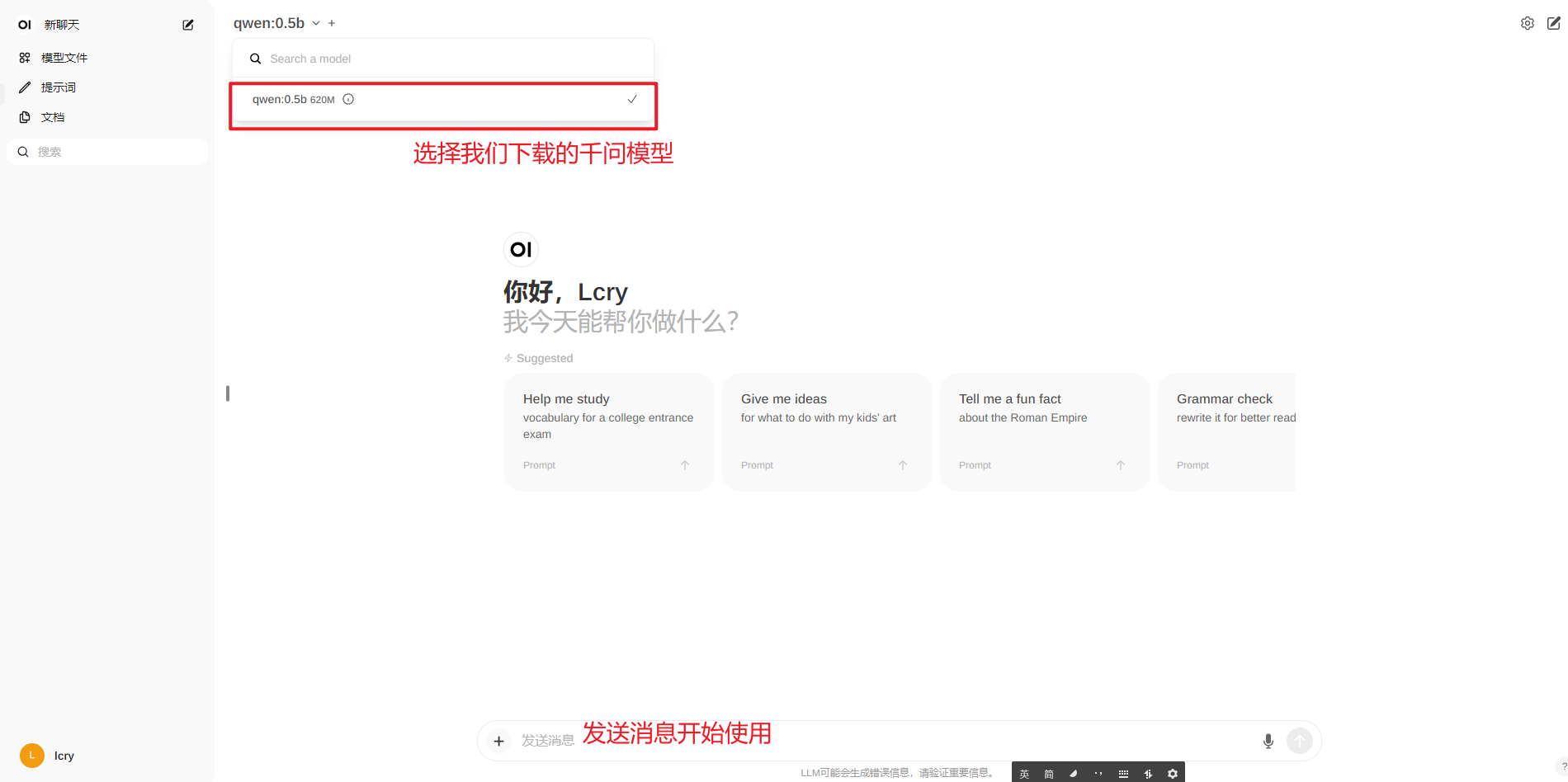

更多界面设置自行研究,然后我们回到首页进行问答,

对接one-api

什么是one-api?

OpenAI 是一个接口管理 & 分发系统,支持 Azure、Anthropic Claude、Google PaLM 2 & Gemini、智谱 ChatGLM、百度文心一言、讯飞星火认知、阿里通义千问、360 智脑以及腾讯混元,可用于二次分发管理 key,仅单可执行文件,已打包好 Docker 镜像,一键部署,开箱即用.

直接执行下面命令docker快速安装one-api:

docker run --name one-api -d --restart unless-stopped -p 3000:3000 -e TZ=Asia/Shanghai -v ./data/one-api:/data justsong/one-api然后访问 http://localhost:3000 ,默认账号密码 root/123456

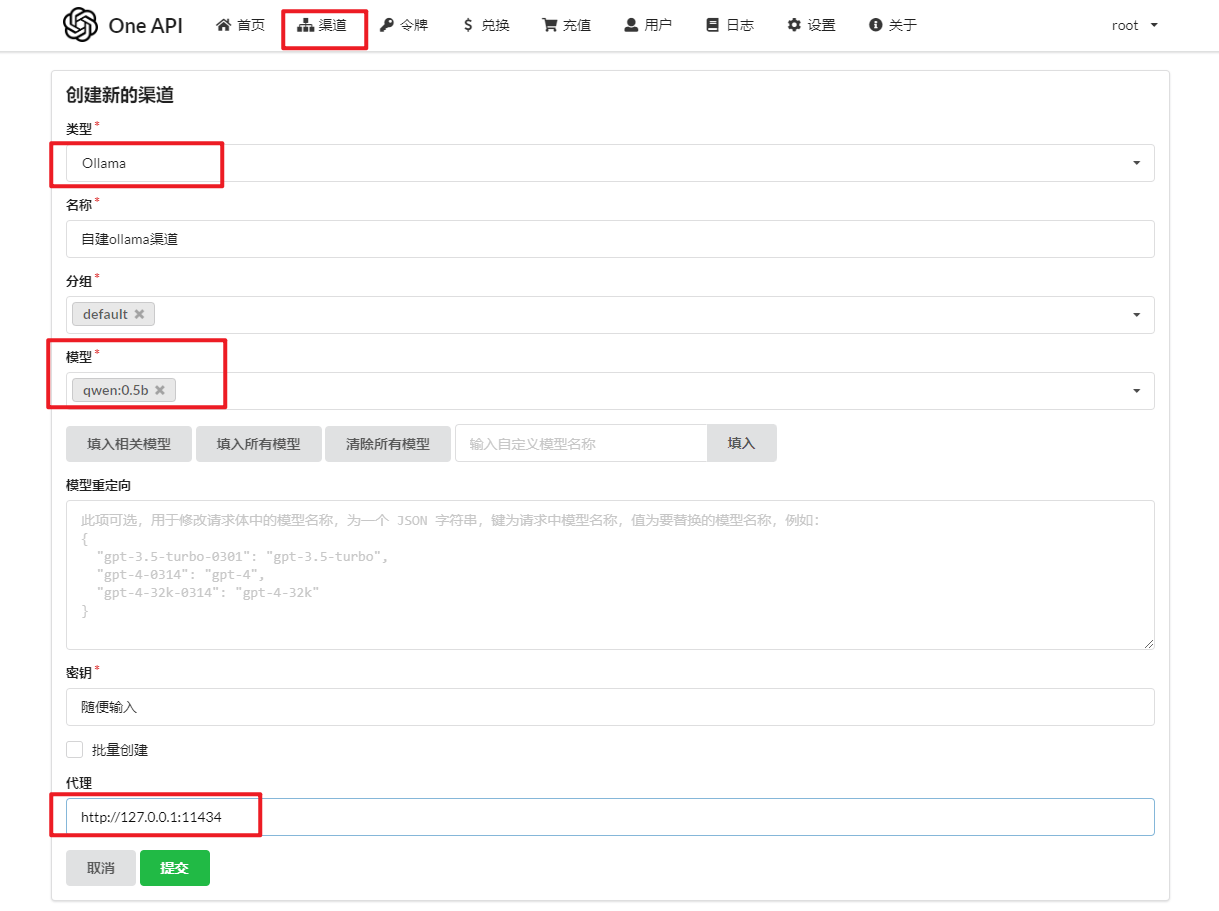

然后依次点击渠道,新增一个渠道ollama,如下图配置:密钥随便输入即可。

然后测试渠道是否可以使用,那么就可以直接对外开放给任何系统使用了,比如前面文章讲的chat-next-web,文章《纯零成本自建 ChatGPT 私人应用》。

chat-next-web对接one-api

先依次点击one-api顶部的令牌,创建一个令牌。

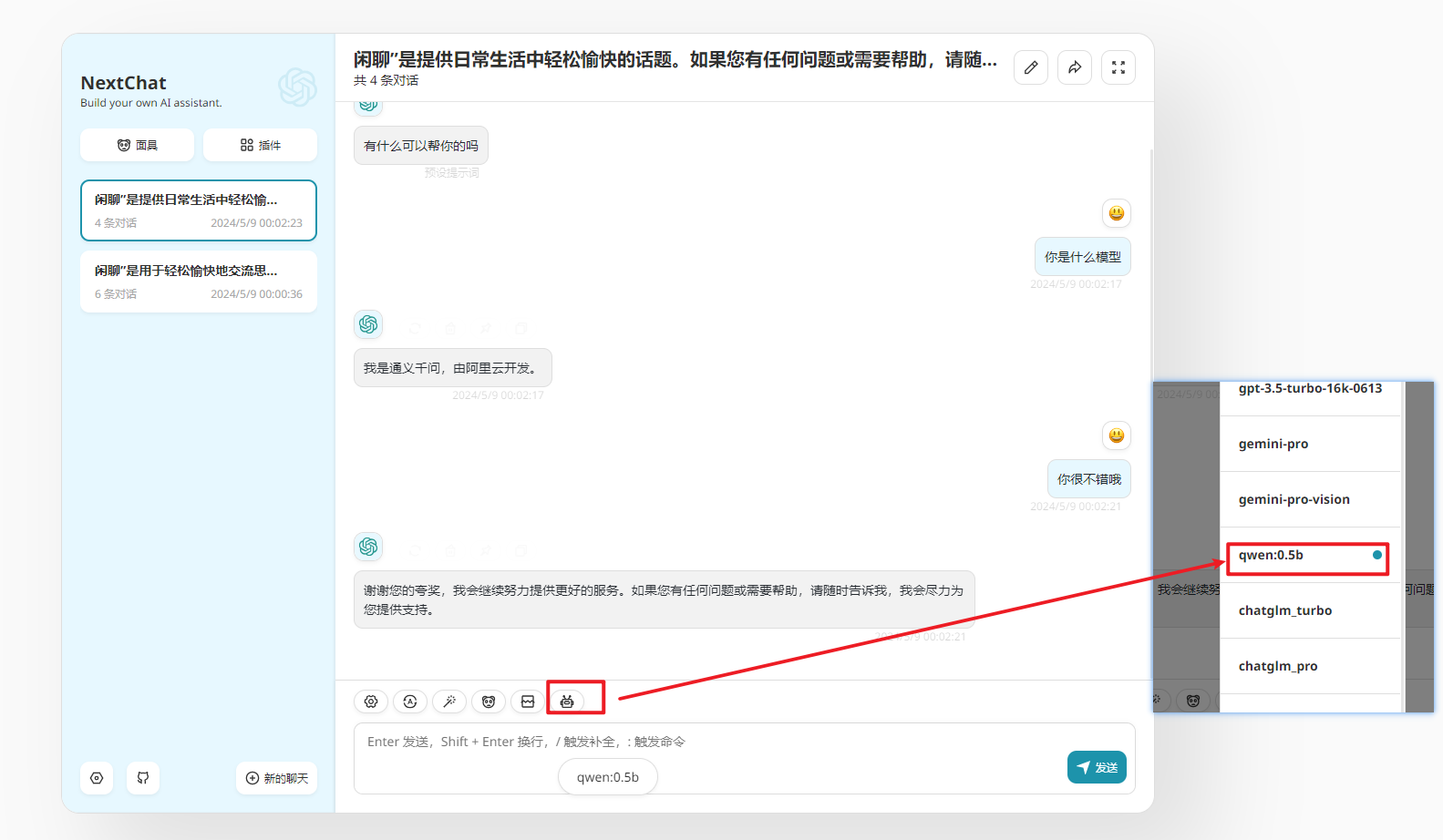

复制sk,然后去chat-next-web配置,如下图:

然后选择开始聊天,选择ollama的模型:

查看one-api日志信息,使用的是ollama模型,自己的sk信息,对接完成,可以直接进行二次分发盈利。

常见问题

1、 如何查看我的GPU是否支持?

答:请前往查看 https://github.com/ollama/ollama/blob/main/docs/gpu.md 查看,N卡、A卡都可以的:

2、 模型的存放位置能改吗,我C盘存不下!

答:可以,设置OLLAMA_MODELS环境变量的值即可,下面是你如果不设置模型会下载到默认指定位置。

- macOS:

~/.ollama/models - Linux:

/usr/share/ollama/.ollama/models - Windows:

C:\Users\%username%\.ollama\models

3、 支持运行那些?模型在哪里找?

答:进入https://ollama.com/library,直接搜索即可

4、运行不同模型需要多高的内存配置以及模型大小?

答:您应该至少有 8 GB 可用 RAM 来运行 7B 型号,16 GB 来运行 13B 型号,32 GB 来运行 33B 型号。

参考链接

ollama官网:https://ollama.com/

ollama帮助文档:https://github.com/ollama/ollama/blob/main/docs/faq.md

ollama github:https://github.com/ollama/ollama/tree/main

open-webui github: https://github.com/open-webui/open-webui

openwebui官网:https://openwebui.com/

one-api github:https://github.com/songquanpeng/one-api

商业转载请联系作者获得授权,非商业转载请注明本文出处及文章链接

这篇文章写得深入浅出,让我这个小白也看懂了!